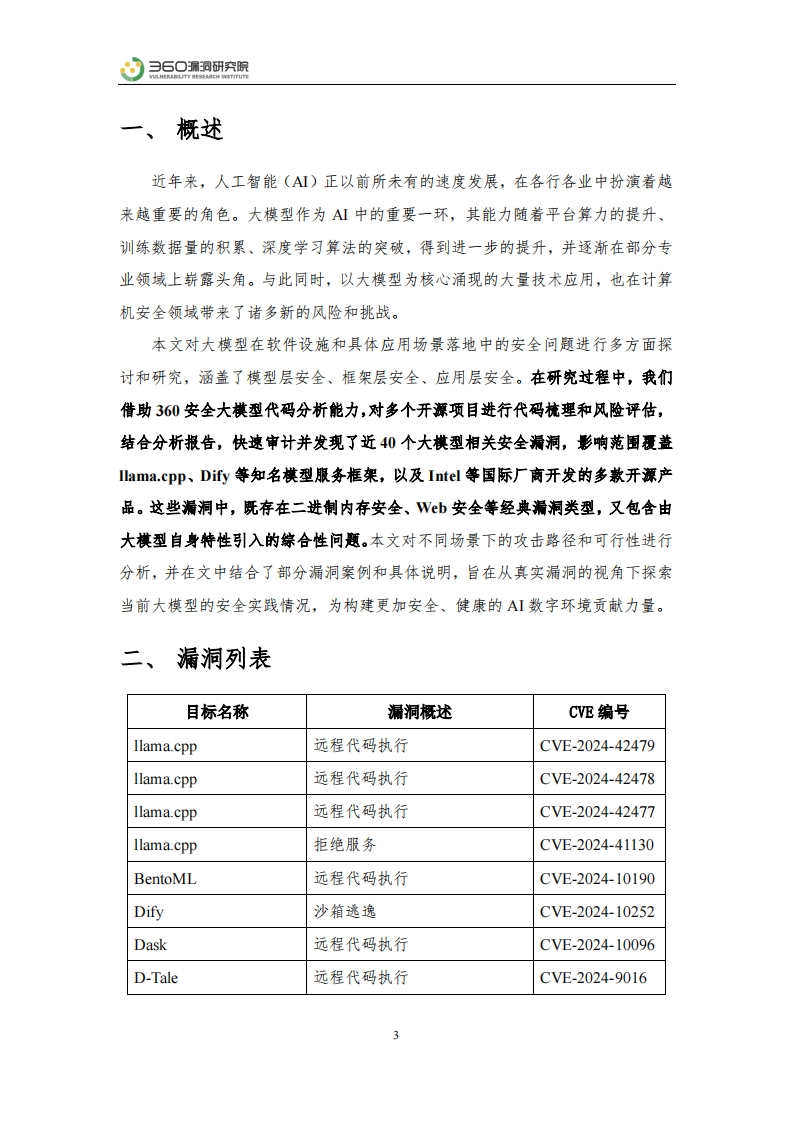

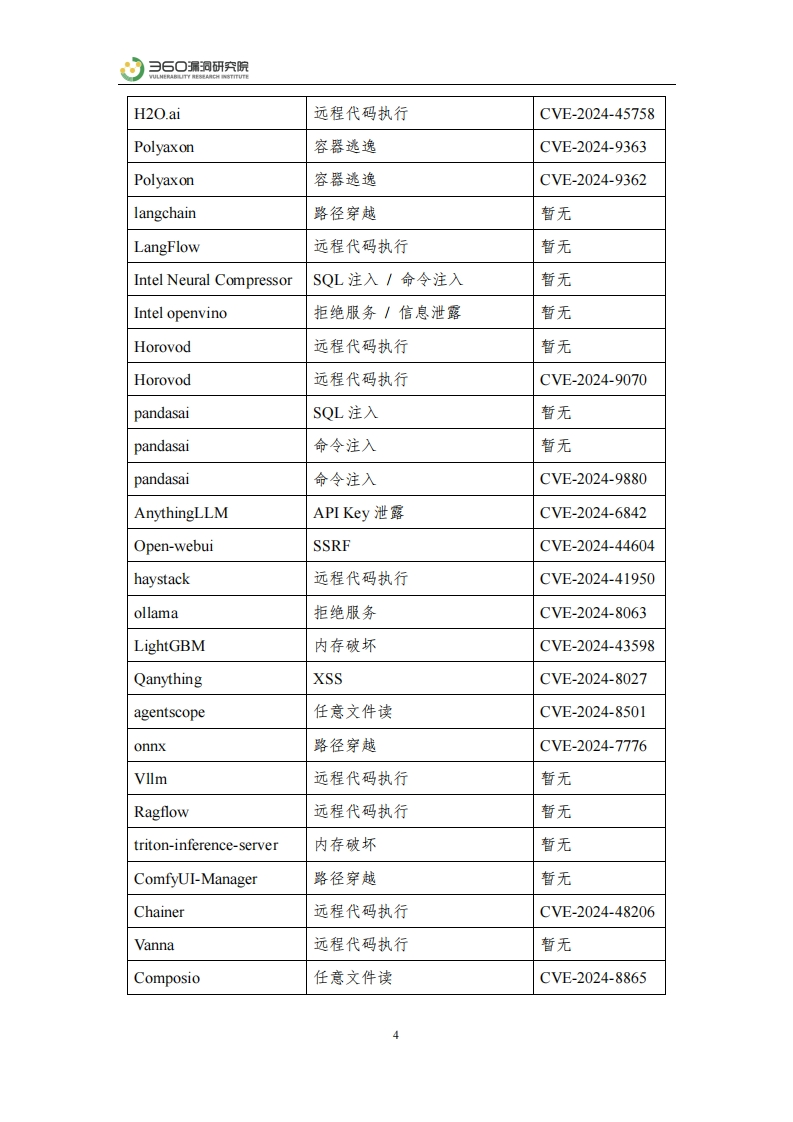

)月O漏润研究所一、概述近年来,人工智能(AI)正以前所未有的速度发展,在各行各业中扮演着越来越重要的角色。大模型作为AI中的重要一环,其能力随着平台算力的提升、训练数据量的积累、深度学习算法的突破,得到进一步的提升,并逐渐在部分专业领域上崭露头角。与此同时,以大模型为核心涌现的大量技术应用,也在计算机安全领域带来了诸多新的风险和挑战。本文对大模型在软件设施和具体应用场景落地中的安全问题进行多方面探讨和研究,涵盖了模型层安全、框架层安全、应用层安全。在研究过程中,我们借助360安全大棋型代码分析能力,对多个开源项目进行代码杭理和风险评估,结合分析报告,快速审计并发现了近40个大模型相关安全漏洞,影响范围覆盖llama..cpp、Dfy等知名模型服务框架,以及Intel等国际厂商开发的多款开源产品。这些漏洞中,既存在二进制内存安全、Vb安全等经典漏洞类型,又包含由大模型自身特性引入的综合性问题。本文对不同场景下的攻击路径和可行性进行分析,并在文中结合了部分漏洞案例和具体说明,旨在从真实漏洞的视角下探索当前大模型的安全实践情况,为构建更加安全、健康的AI数字环境贡献力量。二、漏洞列表目标名称漏洞概述CVE编号llama.cpp远程代码执行CVE-2024-42479llama.cpp远程代码执行CVE-2024-42478llama.cpp远程代码执行CVE-2024-42477llama.cpp拒绝服务CVE-2024-41130BentoML远程代码执行CVE-2024-10190Dify沙箱逃逸CVE-2024-10252Dask远程代码执行CVE-2024-10096D-Tale远程代码执行CVE-2024-9016

暂无评论内容