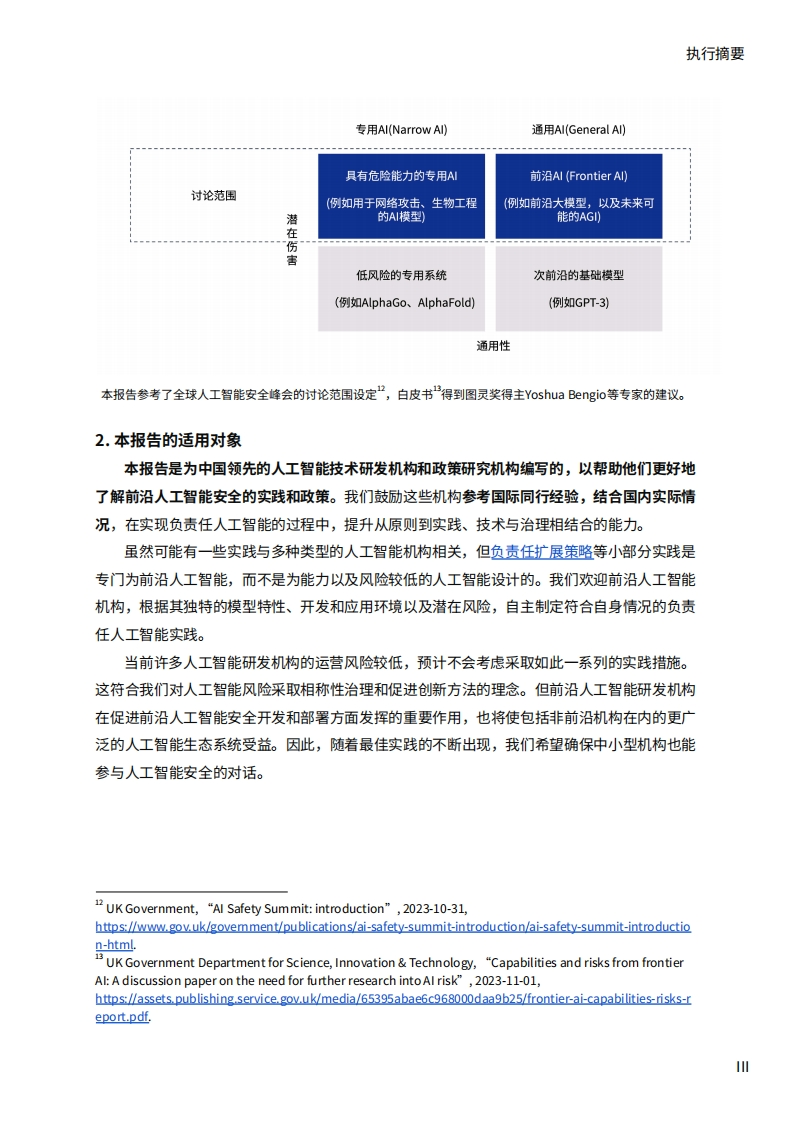

前沿人工智能安全的最佳实践推动前沿人工智能安全的工作刻不容缓GPT-4等前沿大模型展现出强大的涌现能力,在多领域逼近人类水平。同时,大模型为多个技术方向带来新的发展空间,包括多模态、自主智能体、科学发现等能力。模型能力在未来几年内仍存在数量级进步的空间。Inflection在未来18个月内将使用比当前前沿模型GPT-4大100倍的计算量。Anthropic预计在未来的5年里用于训练最大模型的计算量将增加约1000倍。由于大模型的涌现能力,这些更先进人工智能系统所带来的机遇和风险具有巨大不确定性。短期内,社会需要积极预防人工智能所带来的网络安全、生物安全和虚假信息的滥用风险。与此同时,人工智能正获得越来越强的社交操纵、欺骗和战略规划等潜在危险能力,未来先进的自主人工智能系统将带来前所未有的控制挑战。面对科技伦理和公共安全的重大风险,社会应该具备底线思维,凡事从最坏处准备,努力争取最好的结果。全球人工智能安全峰会中讨论了应对潜在风险的人工智能安全级别(ASL)框架,参考了处理危险生物材料的生物安全级别(B$L)标准”,基本思想是要求与模型潜在风险相适应的安全、安保和操作标准,更高的ASL级别需要越来越严格的安全证明。预计未来半年内,我国多个前沿大模型将达到或突破GPT-4性能,达到ASL-2能力级别。确保相适应的安全标准,行业自律和政府监管缺一不可。本报告力求促进前沿人工智能安全的中国方案和实践落地1.本报告的讨论范围本报告聚焦的“前沿人工智能(Frontier Al)”,是指高能力的通用AI模型,能执行广泛的任务,并达到或超过当今最先进模型的能力,最常见的是基础模型。前沿人工智能提供了最多的机遇但也带来了新的风险本报告提供了前沿人工智能机构潜在的最佳实践清单,以及面向中国机构的研发实践案例与政策制定指南。这些是经过广泛研究后收集的,考虑到这项技术的新兴性质,需要定期更新。安全过程并未按重要性顺序列出,而是按主题进行总结,以便读者能够理解、解释和比较前沿机构的安全政策,及其在国内的适用性。本报告参考了各个前沿人工智能机构公布的最佳实践、英国政府《前沿人工智能安全的新兴流程》、国内外相关政策法规等多份参考资料(详见附录A)。Jason Wei et al,"Emergent Abilities of Large Language Models",2022-08-31,https://openreview.net/forum?id=yzksuszdwD.Wikipedia,"Biosafety Leve-1-0,https://enwikipediar/wiki/Biosafety levelAnthropic,"Anthropic's Responsible Scaling Policy",2023-09-19,https://www-files.anthropic.com/production/files/responsible-scaling-policy-1.0.pdf

暂无评论内容