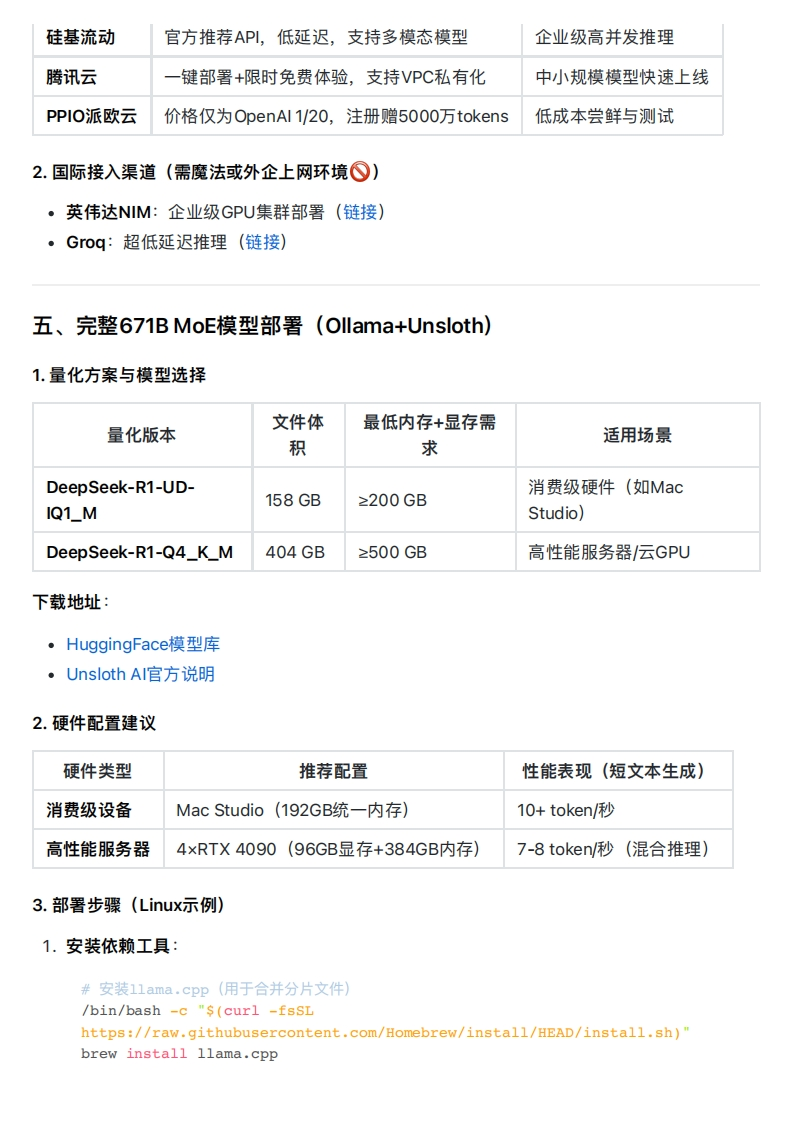

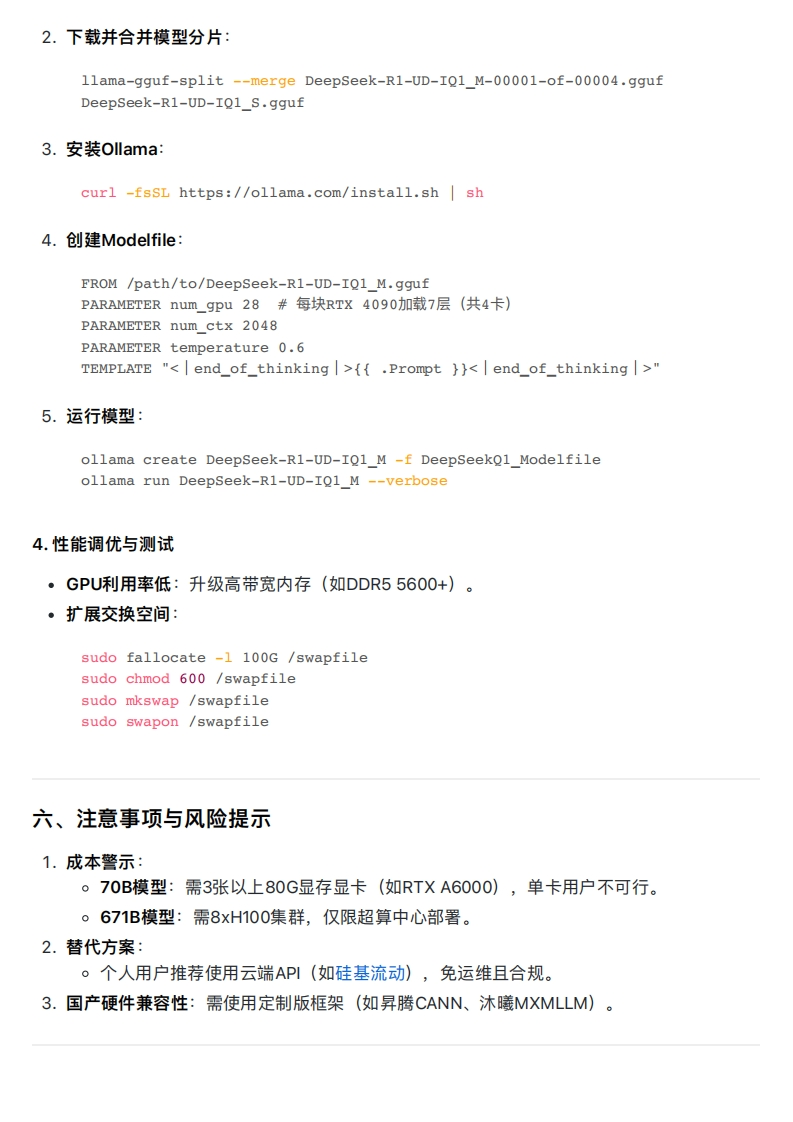

硅基流动官方推荐API,低延迟,支持多模态模型企业级高并发推理腾讯云一键部署+限时免费体验,支持VPC私有化中小规模模型快速上线PPIO派欧云价格仅为OpenAl1/20,注册赠5000万tokens低成本尝鲜与测试2.国际接入渠道(需魔法或外企上网环境⊙)》·英伟达NIM:企业级GPU集群部署(链接)·Goq:超低延迟推理(链接)五、完整671BMoE模型部署(Ollama+Unsloth)1.量化方案与模型选择文件体最低内存+显存需量化版本适用场景积求DeepSeek-R1-UD-消费级硬件(如Mac158GB≥200GBIQ1_MStudio)DeepSeek-R1-Q4_K_M404GB≥500GB高性能服务器/云GPU下载地址:·HuggingFace模型库·Unsloth Al官方说明2.硬件配置建议硬件类型推荐配置性能表现(短文本生成)消费级设备Mac Studio(192GB统一内存)10+token/秒高性能服务器4×RTX4090(96GB显存+384GB内存)7-8 token/秒(混合推理)3.部署步骤(Linux示例)1.安装依赖工具:#安装11ama.cpp(用于合并分片文件】/bin/bash -c "$(curl -fsSLhttps://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"brew install llama.cpp

暂无评论内容